L’inscription à UP’ est totalement gratuite

- Elle vous permet d’entrer dans le cercle des lecteurs de UP’

- De lire trois articles gratuitement pour découvrir UP'

- De recevoir nos newsletters

L’inscription est sans aucun engagement de votre part11

Dans les grandes rubriques de UP'

::: Planète

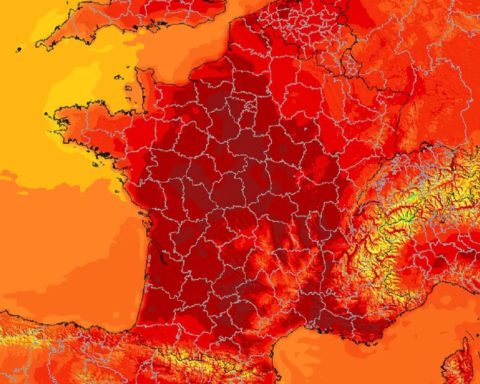

VOIR TOUTE LA RUBRIQUE →CLIMAT ::: BIODIVERSITE ::: TRANSITION ECOLOGIQUE ::: RESSOURCES

::: Planète

VOIR TOUTE LA RUBRIQUE →

Depuis le lancement de la Décennie des océans en 2021, plus de 500 projets ont été lancés à travers le

...LIRE

C’est une décision historique pour le climat contre un État ! Les décisions rendues ce matin dans les affaires “Carême

...LIRE

Des obstacles persistants empêchent les énergies renouvelables de répondre à la demande énergétique croissante, entraînant une augmentation des émissions de

...LIRE

Le GIEC est sans appel : les impacts du changement climatique menacent la prospérité et le bien-être de l’humanité et

...LIRE

Depuis le lancement de la Décennie des océans en 2021, plus de 500 projets ont été lancés à travers le monde pour en améliorer la connaissance et la protection. On sait parfaitement

...LIRE::: Alimentation & Agrostratégies

PLUS →

Les pesticides, fongicides et autres herbicides développés dans les labos de Bayer depuis des décennies ont ruiné l’environnement et la

...LIRE

Bien que globalement non durable, le système alimentaire actuel perdure car ses externalités négatives, du champ à l’assiette, ne sont

...LIRE

Dans le monde de la biologie, la communication entre les plantes et leur environnement demeure l’un des champs les plus

...LIRE::: Décryptages

PLUS →ANALYSES ::: ETUDES ::: POINTS DE VUE

::: Décryptages

PLUS →

Au cœur d’un monde secoué par des actes de violence à une échelle massivement destructrice, la question de la nature

...LIRE

Dans un contexte global marqué par une crise de confiance envers les institutions, la gouvernance émerge comme un pilier central

...LIRE

Ce mercredi 13 mars, le Parlement européen a adopté l’AI Act*, loi européenne sur l’intelligence artificielle, unique au niveau mondial.

...LIRE

Si, comme moi, vous n’en pouvez plus du vocabulaire guerrier qui nous distrait dangereusement des priorités terrestres, je vous invite

...LIRE::: VIVANT

VOIR TOUTE LA RUBRIQUE →SANTE-MEDECINE ::: BIOINNOVATIONS ::: TRANSHUMANISME ::: NANOTECHNOLOGIES ::: NEUROSCIENCES

::: VIVANT

VOIR TOUTE LA RUBRIQUE →

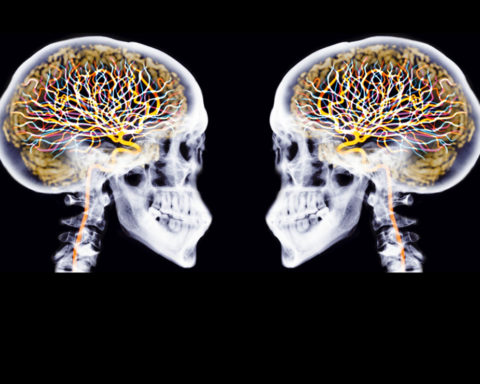

Les maladies affectant le système nerveux – tels que les accidents vasculaires cérébraux, les migraines et la démence – ont

...LIRE

Tous les créatifs qu’ils soient musiciens, écrivains, poètes ou codeurs informatiques ont déjà expérimenté ce moment où leur création semble

...LIRE

« La vieillesse est un naufrage », selon le Général de Gaulle. Pas forcément … Une équipe de l’Inserm (1)

...LIRE

Le dérèglement climatique augmente de 60 % le nombre de naissances prématurées. Le réchauffement climatique entraîne des répercussions que tout

...LIRE::: Vies d'ailleurs

PLUS →

« Londres, première ville intelligente dans le top 10 mondial », « La transition énergétique jugée trop lente au Royaume-Uni », « L’été où les conservateurs

...LIRE

Alors que les négociations de la Cop28 se déroulaient dans les luxueux salons de Dubaï, pas moins de 42 familles

...LIRE

On les appelle peuples premiers. Issus d’une civilisation souvent plusieurs fois millénaires, ils sont, malgré cette antériorité, menacés de disparition.

...LIRE

Depuis le début de la guerre entre Israël et le Hamas, les Vingt-Sept ne parlent pas d’une seule et même

...LIRE::: Société

VOIR TOUTE LA RUBRIQUE →EDUCATION ::: SERVICES ::: SOLIDARITES ::: INFORMATION ::: TERRITOIRES ::: TRANSITION NUMERIQUE

::: Société

VOIR TOUTE LA RUBRIQUE →

Karibu, c’est le nom de l’application pour smartphone gratuite créée par l’ONG Bibliothèques Sans Frontières (BSF), quelques mois après le début de la guerre en Ukraine, pour se familiariser rapidement avec la

...LIRE

Toutes les actions humanitaires ont globalement les mêmes buts et la même

...LIRE

L’intelligence artificielle s’inscrit dans la longue liste des innovations scientifiques et technologiques

...LIRE

Les îles Canaries, archipel espagnol au large de la côte nord-ouest de

...LIRE::: Sciences & Technologies

VOIR TOUTE LA RUBRIQUE →DANS LE SECRET DES LABS ::: INTELLIGENCE ARTIFICIELLE ::: MOBILITES ::: TECHNOLOGIES DE POINTE, DESIGN

::: Sciences & Techno

PLUS →

Les pesticides, fongicides et autres herbicides développés dans les labos de Bayer depuis des décennies ont ruiné l’environnement et la santé humaine.

...LIRE

Dans un contexte où l’intelligence artificielle (IA) se trouve souvent au cœur des débats sur son impact environnemental, Gilles Babinet propose une

...LIRE

En septembre 2023, Elisabeth Borne alors Première Ministre a annoncé la création de la Commission de l’intelligence artificielle qui rassemble des acteurs

...LIRE::: Villes de demain

VOIR TOUTE LA RUBRIQUE →ARCHITECTURE ::: URBANISME ::: PAYSAGE ::: MATERIAUX INNOVANTS

::: Villes de demain

PLUS →::: Billets d'humeur

::: Actus en bref

::: Le hit parade des articles les plus lus de UP' Magazine